Investigadores de la Universidad de San Francisco han desarrollado una interfaz neuronal que permite a los pacientes sin el uso de la palabra "hablar" a través del dispositivo.

Es un hito en el campo de las prótesis neurales: el sistema monitoriza la actividad del cerebro y la convierte en palabras mediante una voz artificial (como las de los asistentes de voz de Google o Amazon, por así decirlo). El software es muy avanzado e incluye una reconstrucción virtual precisa de la laringe, lengua, labios y mandíbula.

¿Por qué perdemos nuestra palabra?

Los pacientes pierden la capacidad de hablar por diversas razones: enfermedad degenerativa, accidentes o daño cerebral. Las tecnologías ya en uso permiten que algunos pronuncien algunas palabras “traduciendo” pequeños movimientos faciales o utilizando otros mecanismos que hacen que la comunicación en cualquier caso sea muy larga y laboriosa.

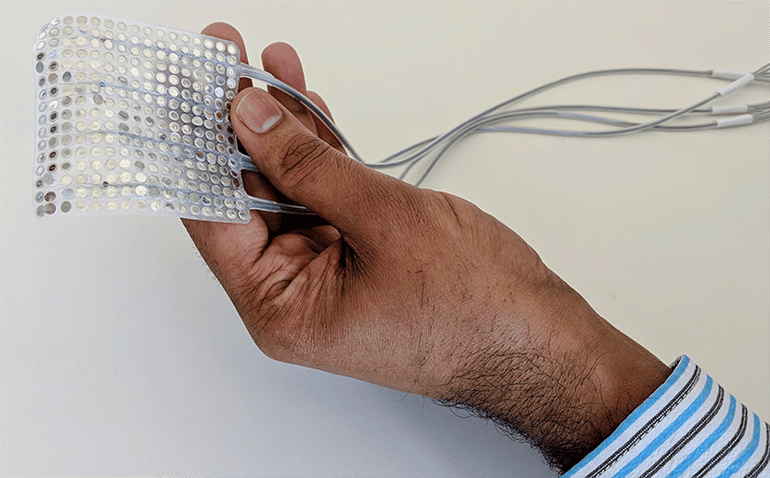

La interfaz neuronal estudiada en San Francisco traduce directamente la actividad cerebral a un lenguaje que suena natural, utilizando una infraestructura que "imita" la forma en que los centros del lenguaje coordinan los movimientos del tracto vocal.

"La relación entre los movimientos del tracto vocal y los sonidos de las palabras es realmente compleja", dados Gopala Anumanchipalli, uno de los investigadores involucrados en el proyecto. "Pensamos que si estos centros del lenguaje codifican los movimientos y los traducen de alguna manera, también podemos hacer esta operación a partir de las señales del cerebro"..

¿En qué consiste?

Es por eso que el equipo ha creado un tracto vocal "virtual" que utiliza el aprendizaje automático para producir gradualmente sonidos cada vez más correctos. Un grupo de voluntarios pronuncia frases específicas mientras se monitorea su actividad cerebral: la inteligencia artificial empleada escanea estas señales y las compara con los movimientos del tracto vocal para comprender exactamente cómo se traducen en ese sonido específico.

"Tenemos la capacidad de imitar perfectamente el lenguaje hablado", dados Josh Chartier, otro de los investigadores. “Ya estamos muy avanzados para sonidos más lentos o más suaves, como 'sh' o 'z', pero nos cuesta mucho los truncados como 'b' y 'p'. Sin embargo, el nivel de precisión aumenta a una velocidad sorprendente gracias al uso del aprendizaje automático ”.

"Las personas que no pueden mover los brazos y las piernas han aprendido a controlar las prótesis robóticas con el cerebro". Chartier continúa. "Confiamos en que algún día las personas con discapacidades del habla aprenderán a hablar a través de esta prótesis de voz nuevamente".

Publicado en Nature