Parece que hay un futuro en el que los pensamientos ya no son sólo imágenes fugaces en nuestra mente, sino que pueden convertirse en vídeos de alta calidad. Y parece un futuro cada vez más cercano a la realidad. Un grupo de investigadores cualificados acaba de abrir la caja de Pandora en el campo de la neurociencia. Para ayudarle, una buena dosis de IA.

El cerebro “proyector”

Jiaxin Qing, Zijiao Chen e Juan Hellen Zhou, de la Universidad Nacional de Singapur y la Universidad China de Hong Kong, presentó un trabajo de investigación bastante interesante. El equipo combinó datos obtenidos de imágenes por resonancia magnética funcional (fMRI) con inteligencia artificial generativa de difusión estable para crear MinD-Video, un modelo que puede generar videos HQ directamente a partir de lecturas cerebrales.

Cosas de ciencia ficción, se podría decir: pero no, todo rigurosamente documentado en arXiv, e este es el enlace.

¿Cómo funciona exactamente MinD-Video?

MinD-Video no es un simple generador de vídeo, sino un sistema completo diseñado para hacer que la decodificación de imágenes realizada por una IA y la realizada por un cerebro se comuniquen. Pero, ¿cómo se entrena un sistema así?

Los investigadores utilizaron un conjunto de datos público, que contenía videos y lecturas de fMRI asociadas de sujetos que los vieron. Y aparentemente el trabajo funcionó admirablemente.

Ver pensamientos, llegamos allí

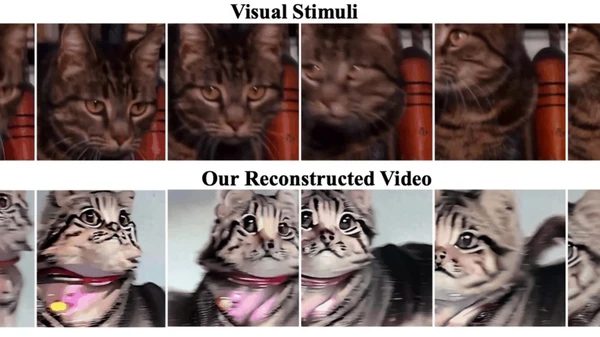

Los vídeos publicados por los científicos muestran resultados realmente fascinantes. Tomemos, por ejemplo, un vídeo original que muestra caballos en un campo. MinD-Video lo "reconstruyó" creando una versión más vibrante de los caballos. En otro caso, un coche circula por una zona boscosa y el vídeo reconstruido muestra un recorrido en primera persona por una carretera sinuosa.

Según los investigadores, los vídeos reconstruidos son de "alta calidad", con movimientos y dinámicas de escena bien definidos. ¿Y la precisión? 85%, una mejora significativa con respecto a la intentos anteriores.

Lectura mental y video HQ, ¿qué sigue?

“El futuro es brillante y las aplicaciones potenciales son inmensas. De la neurociencia a interfaces cerebro-computadora, creemos que nuestro trabajo puede tener un impacto importante”, declararon los autores. Y los hallazgos no terminan ahí: su trabajo destacó el papel dominante de la corteza visual en la percepción visual y la capacidad de su modelo para aprender información cada vez más sofisticada durante el entrenamiento.

El modelo de difusión estable utilizado en esta nueva investigación hace que la visualización sea más precisa. “Una ventaja clave de nuestro modelo sobre otros modelos generativos, como le GAN, es la capacidad de producir videos de mayor calidad. Aprovecha las representaciones aprendidas del codificador fMRI y utiliza su proceso de difusión único para generar videos HQ que se alinean mejor con las actividades neuronales originales”, explicaron los investigadores.

En resumen, parece que realmente hemos entrado en la era de la lectura mental a través de inteligencia artificial. Un campo abierto a mil posibilidades, donde el límite parece ser sólo la imaginación.