Segundo el último informe de las Naciones Unidas sobre la guerra civil libia, el año que termina ha visto por primera vez un sistema de armas autónomo, un robot asesino, matar a alguien. En el futuro podríamos recordarlo como el punto de partida de una nueva carrera armamentista que podría perjudicarnos gravemente.

En los últimos días (del 13 al 17 de diciembre) La Convención de la ONU sobre ciertas armas convencionales reunidos sobre el tema, como ocurre cada cinco años. Desde 1983 esta asamblea ha optado por limitar algunas armas crueles como las minas antipersonal. Esta vez habló de una posible prohibición de estas armas autónomas. Y no ha llegado a un consenso para limitarlos.

Puede que haya sido un error catastrófico.

Los sistemas de armas autónomos son robots asesinos. A lo largo de este post siempre me oiréis llamarlos así: robots asesinos. Porque esto es lo que soy. Sistemas con armas que pueden funcionar por sí solas. Sistemas hechos para la guerra, para matar gente. Los gobiernos del mundo están invirtiendo mucho en esta tendencia.

Por otro lado, por supuesto, las organizaciones humanitarias (una de ellas, Stop The Killer Robots, que encuentras aquí) se gastan pidiendo reglas y prohibiciones sobre el desarrollo de estas armas. Y les va bien. Si no limitamos el uso de armas autónomas, acabará muy mal. Las tecnologías disruptivas en este campo pueden desestabilizar todas las estrategias militares, aumentando el riesgo de ataques preventivos. Incluidos los químicos, biológicos, nucleares.

Dado el ritmo de desarrollo de los robots asesinos, la reunión de la ONU que acaba de terminar puede haber sido una de las ultimas ocasiones para evitar una nueva carrera armamentista. O el último.

Hay cuatro peligros que parecen obvios para cualquiera cuando se trata de sistemas robóticos asesinos.

Primer problema de los robots asesinos: identificación.

¿Las armas autónomas SIEMPRE podrán distinguir entre un soldado hostil y un niño con una pistola de juguete? La diferencia entre un solo error humano (que también es posible) y la configuración incorrecta del algoritmo podría llevar el problema a una escala increíble. Un experto en armas autónomo llamado Pablo Scharre utiliza una metáfora: la de una ametralladora defectuosa que sigue disparando incluso cuando se quita el dedo del gatillo. Y dispara hasta que se acabe la munición, porque es solo una máquina. No sabe que está cometiendo un error.

Diga lo que diga la gente, la inteligencia artificial aún no está equipada con su propia moralidad (y probablemente nunca lo tendrá, nunca podrá aprenderlo).

El problema no es solo ese incluso una IA está mal, por ejemplo cuando reconoce el asma como un factor que reduce el riesgo de neumonía, o cuando identifica a personas de color como gorila. Es que cuando está mal, quien lo creó no sabe por qué estaba mal, y no sabe cómo corregirlo. Por eso creo que es imposible que los robots asesinos puedan desarrollarse con un criterio "moral" de ningún tipo.

Segundo problema con los robots asesinos: la proliferación de gama baja.

Las fuerzas armadas que están desarrollando armas autónomas asumen que podrán contenerlas y controlarlas. ¿Has escuchado una idea más tonta que esta? Si hay una cosa que nos enseña la historia de la tecnología de las armas, solo una es que las armas se propagan. También en este caso era muy predecible.

Lo que sucedió en el pasado con el Kalashinkov, un rifle de asalto que se ha vuelto tan accesible que termina en manos de cualquiera, se puede repetir para los robots asesinos. Las presiones del mercado pueden llevar a la creación de armas autónomas que sean efectivas, baratas y prácticamente imposibles de detener. Sobre todo: generalizado. En manos de gobiernos, caballos locos, crimen organizado o grupos terroristas.

Puede que ya haya sucedido. El Kargu-2, fabricado por un contratista de defensa turco, es un cruce entre un dron y una bomba. Tiene inteligencia artificial para encontrar y rastrear objetivos. Es un robot asesino y ya ha actuado de forma autónoma en el teatro de la guerra civil libia para atacar a las personas.

Tercer problema de los robots asesinos: proliferación de alta gama.

Si luego pensamos en riesgos “high-end”, llegamos a Zenit. Las naciones podrían competir para desarrollar versiones cada vez más devastadoras de armas autónomas, incluidas aquellas capaces de montar armas químicas, biológicas, radiológicas y nucleares . Los peligros morales del aumento de la letalidad por armas se verían magnificados por el aumento del uso de armas.

Claro, es probable que estos robots asesinos vengan con otros costosos. controladores éticos diseñado para minimizar los daños colaterales, siguiendo el mito del ataque "quirúrgico". Un buen material solo para la opinión pública, en resumen. La verdad es que las armas autónomas alterarán incluso el análisis de costo-beneficio más mundano que se hace antes de planificar una guerra. Serán dados de un riesgo mortal, que se lanzarán con menos preocupación.

Las guerras asimétricas libradas en el terreno por naciones que carecen de tecnologías competidoras se volverán más comunes. Una inestabilidad enormemente generalizada.

Cuarto y último problema: las leyes de la guerra

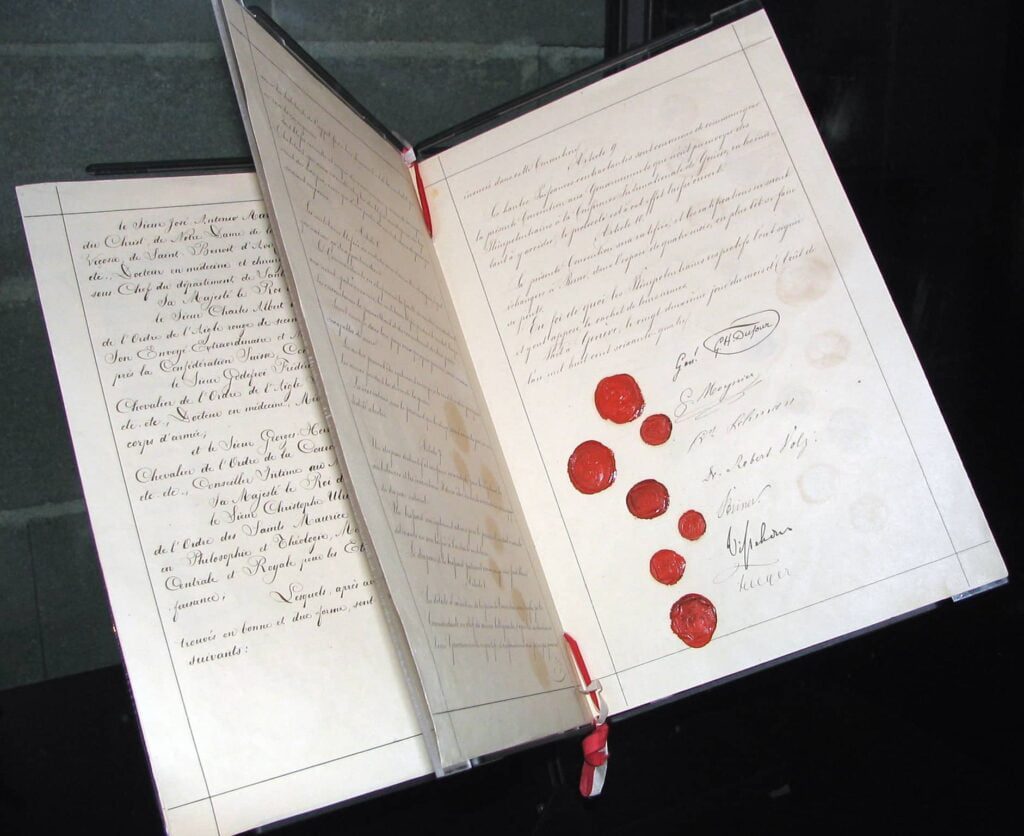

Los robots asesinos (si proliferan, es seguro) socavarán el último paliativo de la humanidad contra los crímenes de guerra y las atrocidades: las leyes de guerra internacionales. Estas leyes, codificadas en tratados que parten del primer Convención de Ginebra, son la delgada línea que separa la guerra de algo aún peor que apenas puedo imaginar.

Las leyes de la guerra son fundamentales, porque también imponen responsabilidad a quienes están librando una guerra. Slobodan Milosevic era el presidente de un país y tuvo que responder por sus acciones. Fue juzgado en el Tribunal Penal Internacional de las Naciones Unidas para la ex Yugoslavia y tenía que responder por lo que hizo.

¿Y ahora? ¿Es culpa de un robot asesino que comete crímenes de guerra? ¿Quién es probado? ¿El arma? ¿El soldado? ¿Los comandantes del soldado? ¿La empresa que fabricó el arma? Las ONG y los expertos en derecho internacional temen que las armas autónomas conduzcan a una tumba brecha de responsabilidad .

Se debe demostrar que un soldado ha cometido un delito utilizando un arma autónoma. Para ello será necesario acreditar que el soldado cometió un acto culpable y además tenía la intención específica de hacerlo. Una dinámica bastante complicada, en un mundo de robots asesinos.

Un mundo de robots asesinos es un mundo sin reglas que impongan control humano significativo en armas. Es un mundo en el que se cometerán crímenes de guerra sin que los criminales de guerra tengan que rendir cuentas. La estructura de las leyes de la guerra, junto con su valor disuasorio, se debilitará considerablemente.

Una nueva carrera armamentista mundial

Imagina que todos pueden usar toda la fuerza que quieran, cuando quieran. Con menos consecuencias para nadie. Imagine un planeta donde militares nacionales e internacionales, grupos insurgentes y terroristas pueden desplegar una fuerza letal teóricamente ilimitada con un riesgo teóricamente cero en los momentos y lugares que elijan, sin responsabilidad legal resultante.