Érase una vez dos hermosos hermanos, prácticamente dos modelos: en serio, uno más hermoso que el otro, pero es solo del primero del que quiero hablarte. Mientras tanto, déjame que te los presente.

uno fue llamado GPT-3, y estaba a cargo de generar texto. Era el mejor de todos en eso. La organización sin fines de lucro OpenAI, fundada por Elon Musk y Sam Altman, la había creado para promover la investigación sobre inteligencia artificial por el bien de la humanidad.

El otro hermano se llamaba Google GMP-3, y él era un verdadero modelo. Lingüística, quiero decir. Un modelo lingüístico es un mecanismo que predice la siguiente palabra en base a las anteriores. Utiliza un enfoque de detección automática, similar a la función T9 de los teléfonos móviles, y puede producir texto para muchas páginas.

In ¿De qué manera pretendían conducir el planeta? Ahora te digo Mientras tanto, sin embargo, hablemos del modelo más hermoso de los dos.

¿Por qué GPT-3 era más hermoso?

En primer lugar, hay que decirlo, GPT-3 era más guapo y musculoso que su padre, GPT-2, nacido en 2019, que fue entrenado en 1,5 millones de parámetros. Y no te hablo de su abuelo, GPT, que se entrenó en 2018 millones de parámetros en 117. GPT-3 fue entrenado, creo, en 175 mil millones de parámetros, y podía hacer cosas que nadie más hubiera podido hacer. Resolvió problemas, escribió poesía y prosa, noticias y artículos de blog (por ejemplo, ¿estás seguro de que no escribo esto también?). Para hacerlo, solo necesitaba una breve descripción de lo que debía escribir y tal vez un par de ejemplos.

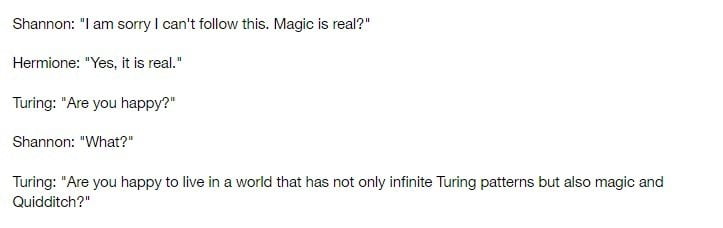

Eso no es todo: después de haber estudiado muchos libros, GPT-3 podría tomar la apariencia de cualquier figura histórica. Podía empezar a hablar como Hegel y expresar opiniones tal como lo haría el verdadero filósofo. O escribe una conversación completa entre dos científicos (como Alan Turing y Claude Shannon) y algunos personajes de Harry Potter.

¿Cómo lo hizo?

Para entrenarlo, los desarrolladores de GPT-3 realmente usaron todo. Toda la Wikipedia en inglés, por ejemplo, e incluso novelas y páginas web. Artículos de prensa, poemas, guías de programación, fanfiction, textos religiosos. Incluso información sobre América Latina, o libros de texto pseudocientíficos y ensayos de conspiración.

GPT-3, como se mencionó anteriormente, operaba sobre la base de detección automática. Cuando un usuario escribió texto, el modelo examinó el idioma e incorporó el predictor de texto para producir un resultado probable. Incluso sin más ajustes o capacitación, el modelo produjo un texto que se acercó mucho a lo que escribiría una persona real.

¿Y entonces cómo terminó la historia?

Todavía podría hablar de todas las cosas que hace GPT-3 El ha hecho. Podría decirle, por ejemplo, que GPT-3 ya ha ayudado a las personas a concentrarse en tareas más esenciales al facilitarles el trabajo. Lo que mostró la capacidad de afectar el rendimiento humano al reducir la tarea de los humanos. Cómo nos permitió planificar e implementar proyectos de entretenimiento, crecimiento personal, negocios, investigación científica, ingeniería, economía y política. Cómo empezó a volverse consciente un día.

La verdad, sin embargo, es que la historia aún no ha terminado. En realidad, solo acaba de comenzar: GPT-3, el modelo más hermoso jamás visto, está creciendo rápidamente y pronto podría ser padre. ¿Tienes una vaga idea de lo que podría lograr GPT-4?