La semana pasada tratamos el tema del pánico inducido por los medios sobre la inteligencia artificial. Una forma como cualquier otra, les decía, de negar un sano debate sobre las oportunidades y los riesgos de esta tecnología que puede cambiar completamente nuestra sociedad. Evidentemente, también está la otra cara de la moneda: un grupo muy grande de científicos a los que no les preocupan en absoluto los posibles peligros. ¿Bien o mal?

Porque hay quienes hacen la vista gorda

“¿Alguna vez has pensado que la inteligencia artificial podría provocar el fin de la humanidad?”. En una reciente conferencia de prensa en la Casa Blanca, la portavoz Karine Jean-Pierre Él rió ante esta pregunta. Lástima que la respuesta sea un serio "no". A pesar de los pioneros de la IA como Alan Turing Ya habíamos advertido sobre los riesgos de que “las máquinas tomaran el control”, a muchos investigadores actuales parece no importarles en absoluto. Sin embargo, la IA está progresando a un ritmo increíble. Entonces, ¿por qué no lo discuten más?

david krueger, profesor del Departamento de Ingeniería de la Universidad de Cambridge, afirma que las razones son sobre todo culturales e históricas. Después de varias fases en las que se depositaron expectativas excesivas e idealistas sobre estas tecnologías (utopía o distopía), los investigadores decidieron pasar a la práctica. Por ello, se centraron en áreas específicas, como la conducción autónoma, deteniéndose para hacer preguntas sobre las implicaciones a largo plazo.

¿Lo hicieron bien o mal? ¿Y si los riesgos fueran reales?

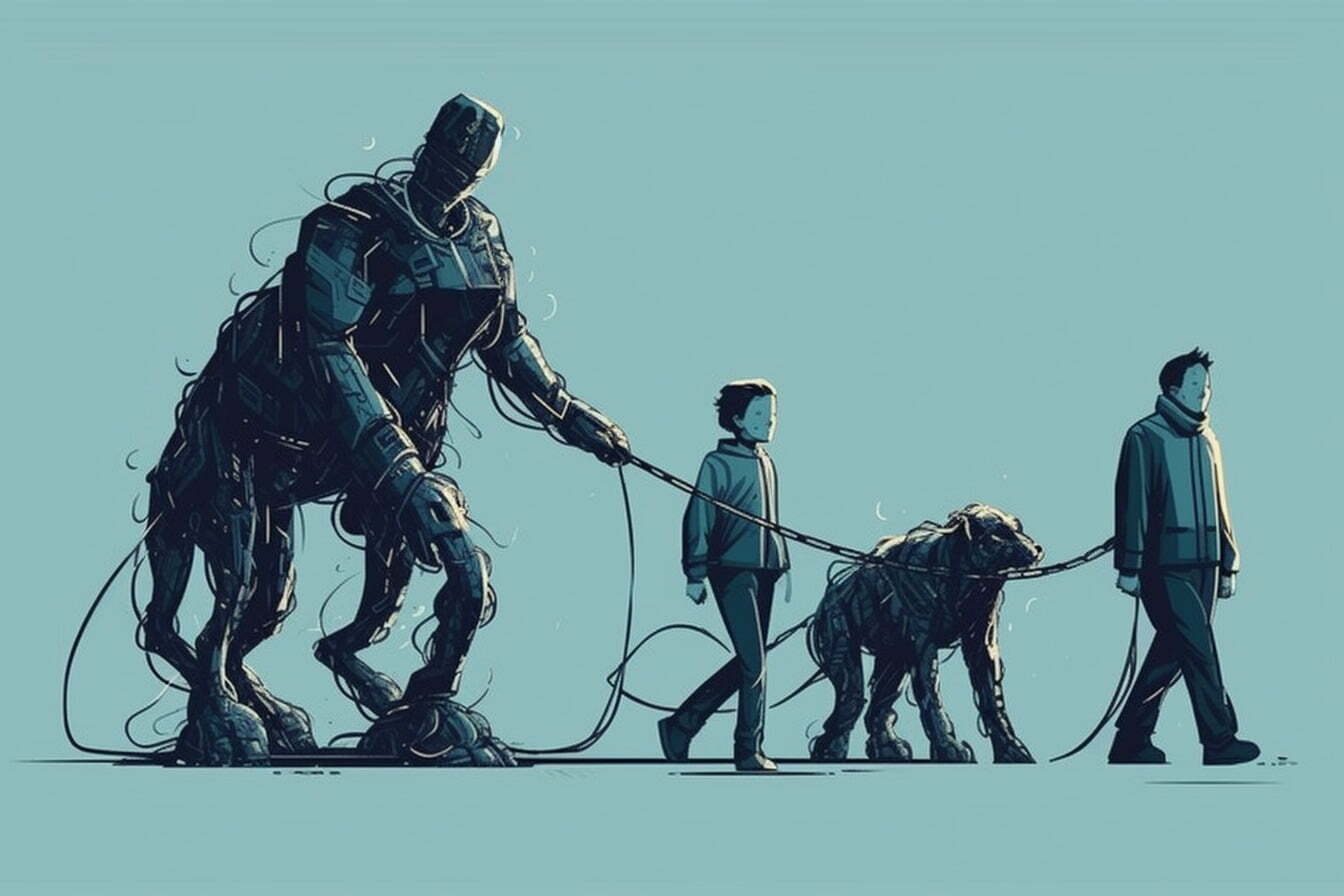

Un argumento básico de los “preocupados” (una categoría muy diferente a la de los “catastrofistas”, claro está) es la analogía entre la IA y los humanos. Así como los humanos hemos extinguido a otras especies para competir por los recursos, la inteligencia artificial podría hacer lo mismo con nosotros. En otras palabras, podría reemplazarnos. Económica y políticamente. Físicamente.

Son temas que suenan enormes, casi de ciencia ficción. Y, de hecho, los riesgos de la IA a menudo se ignoran precisamente porque se consideran "no científicos". Sin embargo, esto no justifica la falta de atención. Más bien, deberíamos abordar estos problemas como lo hacemos con otras cuestiones sociales complejas. Y aquí entra en juego un elemento crucial: la financiación. La mayoría de los investigadores de IA reciben financiación de gigantes tecnológicos, lo que crea posibles conflictos de intereses que pueden influir en la forma en que los expertos abordan los problemas de la IA, lo que lleva a una negación de los riesgos en lugar de una evaluación objetiva de las posibles amenazas.

Por eso, en lugar de "inclinarse" hacia uno de los dos polos, en el ejercicio que más les gusta a quienes guían las finanzas y los medios (divide y vencerás), la opinión pública debería mirar hacia adelante, o más bien hacia adentro. Cosas internas, exigiendo que se profundice en el tema.

es hora de ponerse serio

Los riesgos existenciales de la IA pueden ser más especulativos que reales en comparación con cuestiones urgentes como los prejuicios y las noticias falsas, pero la solución básica es la misma: la regulación. Es hora de iniciar un debate público sólido y abordar las cuestiones éticas relacionadas con la IA. Todo lo demás es aburrimiento, o mejor dicho, embotamiento.

Porque lo sabemos: no podemos darnos el lujo de ignorar los riesgos potenciales de la inteligencia artificial para la humanidad. Es esencial un debate público abierto y honesto, que tenga en cuenta los conflictos de intereses y las responsabilidades éticas. Sólo así podremos entender si la risa de una portavoz de la Casa Blanca es verdaderamente apropiada o, por el contrario, una señal de (esto es) peligrosa inconsciencia colectiva.